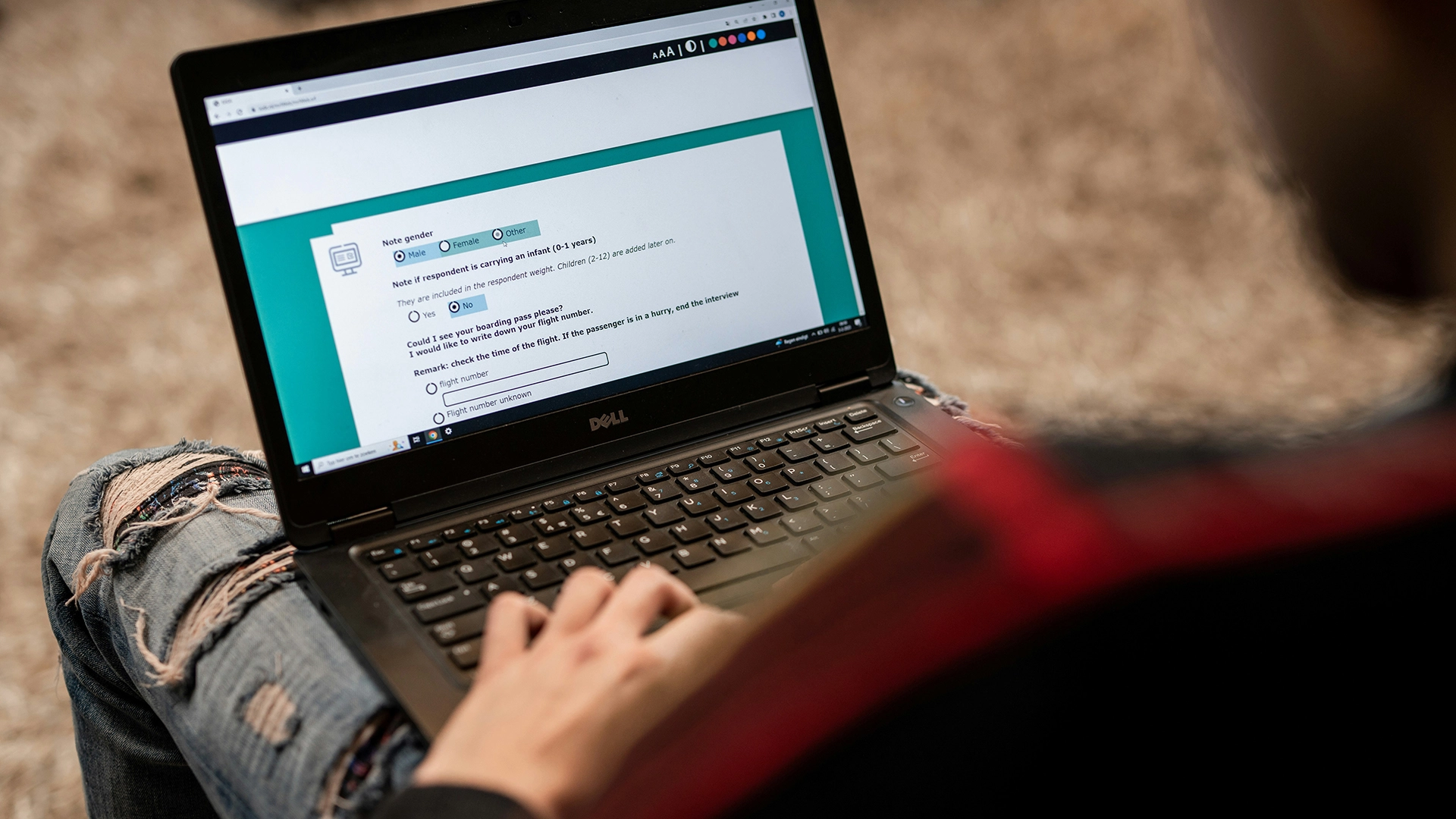

Image by ODISSEI, from Unsplash

Çalışma, Online Anket Yanıtlarının Neredeyse Yarısının AI’dan Geldiğini Buluyor

Önceden insan psikolojisini incelemek için güvenilir bir yöntem olarak kabul edilen çevrimiçi davranışsal araştırmalar, şimdi katılımcıların yanıtlarını oluşturmak için chatbotlar gibi AI araçlarını kullanması sebebiyle büyük bir sorunla karşı karşıya.

Acele mi ediyorsunuz? İşte hızlıca bilgiler:

- Prolific anketine katılanların %45’i AI tarafından oluşturulan yanıtları yapıştırdı.

- Araştırmacılar, chatbot metninin genellikle “aşırı geveze” veya “insan dışı” göründüğünü buldular.

- Uzmanlar, bu durumu “LLM Kirliliği” olarak adlandırıyor ve davranışsal araştırma geçerliliğini tehdit ediyor.

Berlin’deki Max Planck İnsan Gelişimi Enstitüsü’ndeki araştırmacılar yakın zamanda, gönüllülere anket doldurarak ödeme yapan Prolific gibi platformlarda bu sorunun ne kadar yaygın olduğunu araştırdılar.

“Gözlemlediğimiz oranlar gerçekten şok ediciydi,” diye açıklıyor ana araştırmacı Anne-Marie Nussberger, New Scientist (NS) tarafından bildirildiği gibi.

Bir testte, katılımcıların yüzde 45’i, açık uçlu yanıt kutusuna chatbot tarafından üretilen içerik yapıştırmış gibi görünüyordu. Yanıtlar genellikle “aşırı laf kalabalığı” veya “açıkça insan olmayan” dil gibi belirtiler gösteriyordu.

“Bu yılın başında topladığımız verilere göre, çalışmaların önemli bir kısmının kirletildiği görülüyor,” dedi Nussberger NS’ye.

Şüpheli yanıtları tespit etmek için, ekibi gizli tuzaklar yerleştirdi. Basit reCAPTCHA’lar kullanıcıların yüzde 0.2’sini belirledi, daha gelişmiş bir versiyon yüzde 2.7’sini yakaladı, “fındık” kelimesini isteyen görünmez bir metin isteği yüzde 1.6’sını yakaladı ve kopyala-yapıştırın yasaklanması başka bir yüzde 4.7’yi ortaya çıkardı.

Sorun, uzmanların artık “LLM Kirliliği” olarak adlandırdığı bir duruma evrildi ve bu, hile yapmayı aşan bir durum. Araştırma çalışması, üç yapay zeka müdahale modelini ortaya koyuyor: Kısmi Arabuluculuk (AI, kelime seçiminde veya çeviride yardımcı olur), Tam Delegasyon (AI, tam çalışmaları yürütür) ve Sızma (insanlar, AI’nin varlığını öngördükleri için eylemlerini değiştirir).

“Yapmamız gereken şey, tamamen çevrimiçi araştırmalara güvenmemek değil, yanıt vermek ve tepki göstermektir” diyor Nussberger ve NS tarafından bildirildiği gibi platformların sorunu ciddiye almaları çağrısında bulunuyor.

Araştırma etiği danışmanı Matt Hodgkinson, NS’ye uyarıda bulunuyor: “Çevrimiçi davranışsal araştırmanın bütünlüğü zaten sorgulanıyordu […] Araştırmacıların ya uzaktan insan katılımını doğrulamanın yollarını kolektif olarak bulması gerekiyor ya da eski moda yüz yüze iletişim yaklaşımına geri dönmeleri gerekiyor.”

Prolific, NS’ye yorum yapmayı reddetti.

Önceki Hikâye

Önceki Hikâye

Son makaleler

Son makaleler